We can't find the internet

Attempting to reconnect

Something went wrong!

Hang in there while we get back on track

Inteligencia artificial

Sarah Chander: “El discurso de que necesitamos tecnologías de vigilancia para estar seguros está cambiando”

La Unión Europea tendrá este año, si no hay imprevistos de última hora, una ley para controlar el uso de los sistemas de inteligencia artificial (IA). La normativa será la primera de su clase en el mundo: nunca antes un bloque de países de tanto peso político y económico había puesto sobre el papel qué se puede hacer y qué no con estas tecnologías.

El AI Act lleva años cocinándose en Bruselas, desde mucho antes de que ChatGPT entrase en escena. Pero las próximas semanas se antojan decisivas para saber cómo los Estados miembros terminarán de moldear una legislación llamada, en teoría, a convertirse en referencia global. También para potencias como EE UU y China, mucho menos proclives a regular un sector, el tecnológico, dominado por un puñado de corporaciones.

Inteligencia artificial

Inteligencia artificial La inteligencia artificial en la encrucijada: qué hay detrás del ruido sobre ChatGPT

En mayo, dos de los comités que integran el Parlamento Europeo aprobaron varias enmiendas al borrador de la ley escrito por la Comisión Europea. Aunque con algunos matices, las correcciones al texto fueron muy bien recibidas desde las organizaciones en defensa de los derechos civiles. Los europarlamentarios proponen, entre otras cosas, prohibir los sistemas que usan datos biométricos (rasgos faciales, huellas dactilares, etc.) para identificar a una persona en el espacio público. También defienden un veto a las tecnologías para reconocer las emociones y a las herramientas policiales predictivas que tratan de adivinar dónde o quién cometerá el próximo delito.

Con esta ley está en juego nuestra privacidad y cómo interactuamos como ciudadanos con el espacio público. También cómo evitamos las discriminaciones que estas tecnologías provocan

“Es una enorme victoria para nuestros derechos fundamentales”. Así recibió la propuesta del parlamento la European Digital Rights (EDRi), la mayor red de organizaciones por los derechos y libertades digitales del continente. Pero a la ley aún le queda un largo camino hasta entrar en vigor. Esta semana el parlamento confirmará su posición definitiva, que habrá de defender en los próximos meses en los diálogos a tres bandas (o trílogos) junto a la Comisión y el Consejo Europeo, coincidiendo además con la presidencia española de esta última institución.

Antes de que esto ocurra repasamos con Sarah Chander, una de las voces con mayor peso en el activismo europeo en defensa de los derechos digitales y que ha seguido la evolución de la norma desde su gestación, las principales batallas que están por venir. Chander es también responsable de acción política de EDRi, una red que está detrás de campañas como Reclaim your face.

¿Qué está en juego con esta ley?

Esta legislación cubre muchas cuestiones y muchos sistemas de IA. Está en juego nuestra privacidad y cómo interactuamos como ciudadanos con el espacio público. También cómo evitamos las discriminaciones que estas tecnologías provocan. Gobiernos y grandes compañías usan la IA para tomar decisiones sobre nuestras vidas. Esta ley establecerá normas al respecto y determinará qué es aceptable y qué no.

¿Por qué desde EDRi y otros actores de la sociedad civil se recibieron tan bien los cambios que plantea el Parlamento Europeo?

Una de las grandes cuestiones en juego con esta ley, y que venimos advirtiendo desde el principio, es que no se trata sólo de regular los aspectos técnicos de la IA para tratar de mejorar los usos actuales de estas tecnologías, sino que hay que cuestionar la premisa de que ya se estén usando ciertos sistemas para ciertos usos.

Y eso enlaza con el tema de la vigilancia en el espacio público. Por ejemplo, con el hecho de que se nos identifique cuando caminamos por un centro comercial. Pero también con si la IA se puede realmente usar para actividades policiales, en políticas migratorias o para otros sistemas de control.

Uno de los puntos cruciales es cómo regular el reconocimiento facial por parte de la policía. La Comisión estableció en la propuesta de ley excepciones para usar la IA para identificar personas en el espacio público. El Parlamento europeo defiende que no se pueda hacer en ningún caso

¿Qué destacarías entre el conjunto de cambios propuestos?

Uno de los puntos cruciales de la ley es cómo regular el uso del reconocimiento facial por parte de la policía. Inicialmente, la Comisión dijo que no se podía usar para identificar a personas en espacios públicos, pero con grandes excepciones, por lo que permitían que la policía la usase en muchos casos. El Parlamento dijo que no, que el uso de estos sistemas por cualquier actor está prohibido en cualquier circunstancia, sin excepción. Esto supone un enorme impulso a los debates sobre privacidad, protección de la libertad de expresión y la no discriminación.

Observamos un cambio significativo respecto a estos discursos, según los cuales necesitamos tecnologías de vigilancia para estar seguros. El Parlamento dijo lo contrario: en realidad, lo que nos mantiene a salvo es la libertad, no las tecnologías de control y vigilancia.

¿Cuáles son los siguientes pasos, una vez el Europarlamento confirme su posición antes de los diálogos a tres bandas entre Comisión, Parlamento y Consejo?

Si hay suerte, las negociaciones concluirán a finales de año y entonces tendremos un texto definitivo. Pero de aquí a entonces pueden cambiar muchas cosas. Habrá muchas batallas, sobre todo en el ámbito de los derechos humanos y en torno a lo que la policía puede hacer y lo que no. Suponiendo que tengamos el texto final al acabar el año, luego se tardará entre dos y cinco años en que la legislación se adopte y aplique plenamente. Pero una vez esté lista, eso ya manda un mensaje claro, especialmente respecto a las prohibiciones de ciertos sistemas.

Habrá muchas batallas en el debate de esta ley, sobre todo en el ámbito de los derechos humanos y en torno a lo que la policía puede hacer y lo que no

Otra de las novedades son las obligaciones que han de seguir los creadores de los grandes modelos generativos de IA, como ChatGPT, antes de sacarlos al mercado. ¿En qué consisten y por qué son relevantes?

El texto de la Comisión categoriza los sistemas de IA en función de su riesgo: inaceptable, alto, medio y bajo. La mayoría de la normativa está dirigida a las consideradas de alto riesgo. Los negociadores del Parlamento se dieron cuenta que quizás esas categorías no encajan para los sistemas de uso general, porque ese riesgo viene definido por el contexto y el fin para el que se usan. Los grandes modelos generativos de lenguaje pueden tener muchas funciones diferentes en el mercado.

El Parlamento ha decidido separarlos y en el texto actual los llama modelos fundacionales. En lugar de regular a ChatGPT, lo que se miran son los datos de entrenamiento y el modelo sobre el que está construida la herramienta. Y les aplica algunos de los requisitos previstos para los sistemas de alto riesgo, sobre todo en relación a la transparencia.

También tienen que mostrar su nivel de computación. Este es un paso muy interesante porque las implicaciones medioambientales y económicas de estos grandes sistemas a menudo no se discuten. Rara vez hablamos sobre la extracción y el consumo de recursos necesarios para construirlos. Las corporaciones tecnológicas no quieren tener estas conversaciones. Esta es la razón por la que Google despidió a Timnit Gebru.

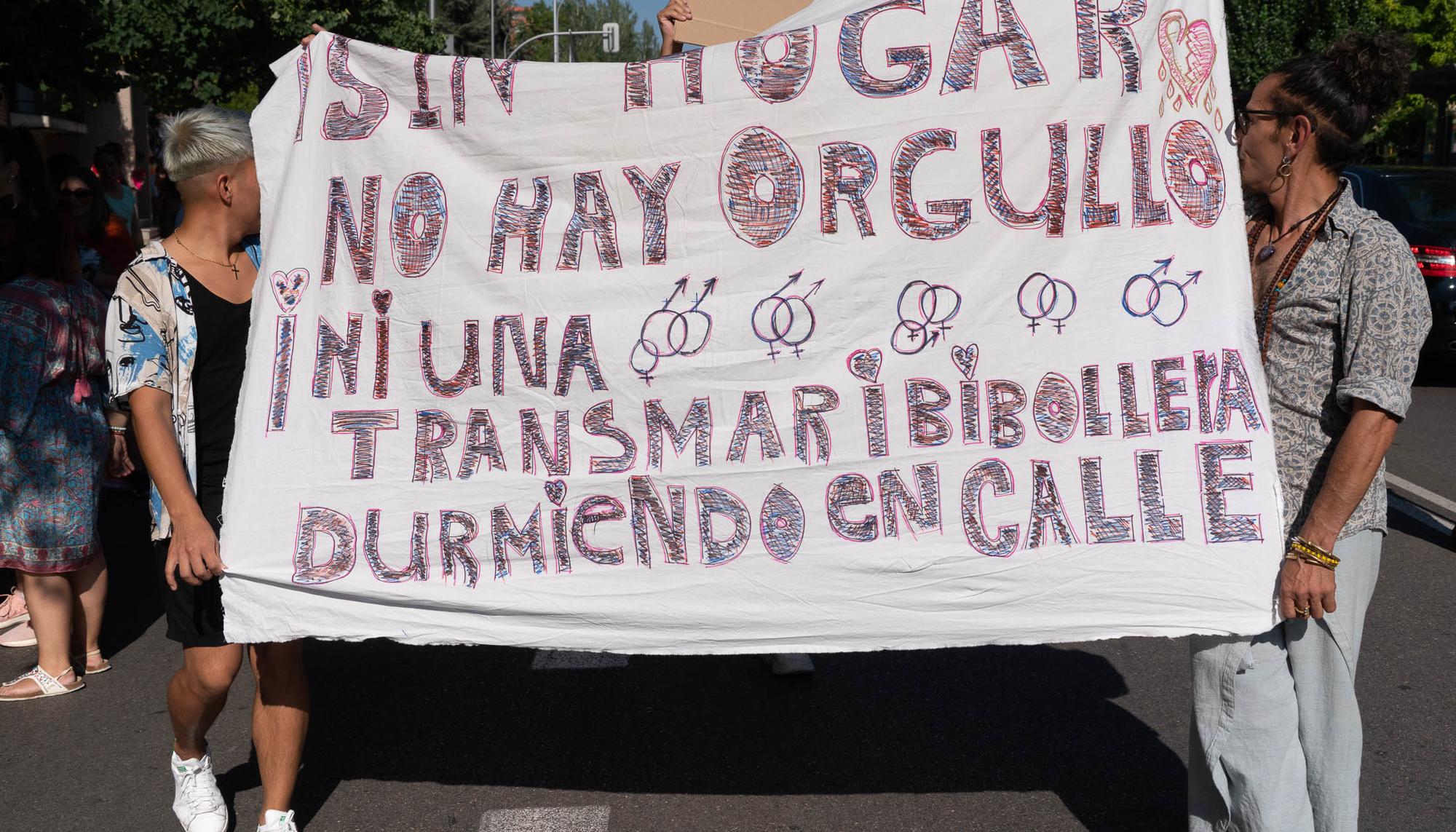

Otra cuestión relevante es la prohibición (o no) de los sistemas biométricos de vigilancia, que algunos países ya están usando o han legalizado a nivel nacional. ¿Cómo se están posicionando los diferentes actores en este asunto?

Habrá una gran batalla en torno a esto en el Consejo Europeo, ya que los Estados miembros tienen diferentes posiciones. Podemos decir que hasta ahora no se quería una prohibición total, pero eso está cambiando con la presión pública y una mayor concienciación sobre lo que implica la vigilancia masiva.

Algunos países como Alemania y Austria están a favor de prohibirlos o limitarlos ampliamente. Francia es un campo de batalla importante con los Juegos Olímpicos en el horizonte. La posición de España en este asunto todavía no está definida.

En el terrorismo existe la falacia de la frecuencia base, que dice que el número de sospechosos de terrorismo es tan bajo que, debido a la tasa de error de estos sistemas, nunca te ayudarán a encontrarlos. Es técnicamente imposible

Vemos diferentes tipos de discursos para justificar su uso: seguridad, terrorismo, la búsqueda de menores desparecidos y otros crímenes graves, etc. Pero hay muy pocas pruebas que demuestren su utilidad. En el terrorismo existe la falacia de la frecuencia base, que dice que el número de sospechosos de terrorismo es tan bajo que, debido a la tasa de error de estos sistemas, nunca te ayudarán a encontrarlos. Es técnicamente imposible.

Desde EDRI habéis advertido que los derechos de las personas migrantes, sin embargo, siguen sin estar protegidos con las últimas enmiendas. ¿Por qué?

Para mí este es uno de los mayores defectos de la ley. Nosotras abogamos por que se prohíban los sistemas para predecir dónde habrá cruces de frontera y así enviar a las autoridades migratorias a esas áreas para impedir que ocurran. Esto es parte de un sistema más amplio de devoluciones ilegales. No puedes impedir que alguien entre en Europa cuando su intención es pedir asilo, eso es una violación de la legislación internacional. A esto le llamamos devoluciones digitales. Estamos hablando del contexto de la Europa Fortaleza. Y nos tememos que la tecnología apoye este proceso.

También defendemos prohibir los sistemas que usan datos personales y sensibles para decidir si hay riesgo de que un solicitante de asilo incurra en inmigración ilegal. Son sistemas discriminatorios

También defendemos prohibir los sistemas que usan datos personales y sensibles para decidir si hay riesgo de que un solicitante de asilo incurra en inmigración ilegal. Son sistemas discriminatorios. No puedes hacer suposiciones sobre algo que no controlas. Ante la IA, las personas en muchos contextos estamos indefensas porque no sabemos dónde se están usando. Es todo muy inmaterial así que es difícil plantar cara a estos sistemas. En migraciones esto es más acusado, porque ya existe un desequilibrio de poder cuando estás solicitando asilo u otro permiso migratorio.

.jpg?v=63824679410)